Apples "Real-Life-Verse", seit 2020 in der US-Beta

Apples Führungsmannschaft vermied von Anfang an in jedem Interview den Begriff "Metaverse". Doch das heisst nicht Apple habe keine eigene Pläne: Meine Spurensuche dazu führen uns bis ins Jahr 2013.

Apple hat zwei Jahre vor Meta sein "Real-Life-Metaverse" in der US-Beta gestartet. Vor unser aller Augen... Daher: Zeit für eine Tasse Tee oder Kaffee?

Ausblick aufs "Real-Life-Metaverse"

An dieser Stelle versuche ich die Technologie in Form zweier kleinen Geschichte zu erzählen. Einen Teil der folgenden Zeilen basiert auf Informationen zur Apple Vision Pro, ein Teil auf meinen eigenen Recherchen zu Apple und Open USD.

Schule

Morgens, vor der Schule. Du bist spät dran, wie immer!

Doch kurz den Status der Freunde checken. Dazu das iPhone zücken, die AR-Taste am Handy antippen und schon aktiviert sich die Kamera. Schnell das iPhone über die Häuser halten und schon tauchen die Chat- und Statusnachrichten der Freude über den Dächern in Augmented Reality auf.

Peter und Bernd sind auf dem Weg zur Schule, doch Woody scheint noch zu Hause zu sein. Seine Statusmeldung zeigt noch immer das Schlafensymbol an.

Vielleicht doch kurz zum Freund Woody rennen, damit er nicht zu Spät zur Schule kommt? Ein kleiner Weckdienst unter Freunden.

Arbeit

Drei Kollegen sind mit Dir im Videocall.

Es geht um die Präsentation eines Lieferanten für seine neue Maschine und deren Vorteile gegenüber dem bisherigen Modell in der Produktion. Dazu stehst Du in der leeren Werkshalle und lädst Du den Vertriebsingenieur des Lieferanten in den Call ein.

Sobald im Rahmen des Sales-Pitches der Verkäufer zur eigentlichen Produktpräsenation kommt können alle Teilnehmer das interaktive Modell der Maschine in AR gemeinsam bedienen. Dazu wird das Modell neben Dir in der Halle erscheinen, genau an der Stelle, wo in Zukunft die Maschine platziert werden soll. Alle wichtigen AR-Funktionen dazu verwaltet das Betriebsystem Deiner AR-Brille Vision Pro.

Mehr zu dem Büro-Setting in dieser Newsletter-Ausgabe: Arbeitstier: Vision Pro von Apple für den deutschen Mittelstand. In einer zukünftigen Ausgabe stelle ich weitere Szenarien für die Vision Pro vor. Gern in den Kommentaren dazu melden - Danke!

Was ist / Wozu das Real-Life-Metaverse?

Disclaimer: Apple nennt sein zukünftiges Produkt sicher NICHT "Reallife-Metaverse", ebenso nicht "AppleVerse" etc. An anderer Stelle verwendete ich schon den Begriff "AR-Cloud". Ich verwende den/die Begriff(e) hier nur zur Umschreibung.

Was ist nun eine einfache Definition?

Reale Orte mit 3D-Daten verbinden (Location Anchors) und diese beim Öffnen einer App auf dem iPhone oder iPad (ab dem iPhone 10) angezeigt bekommen.

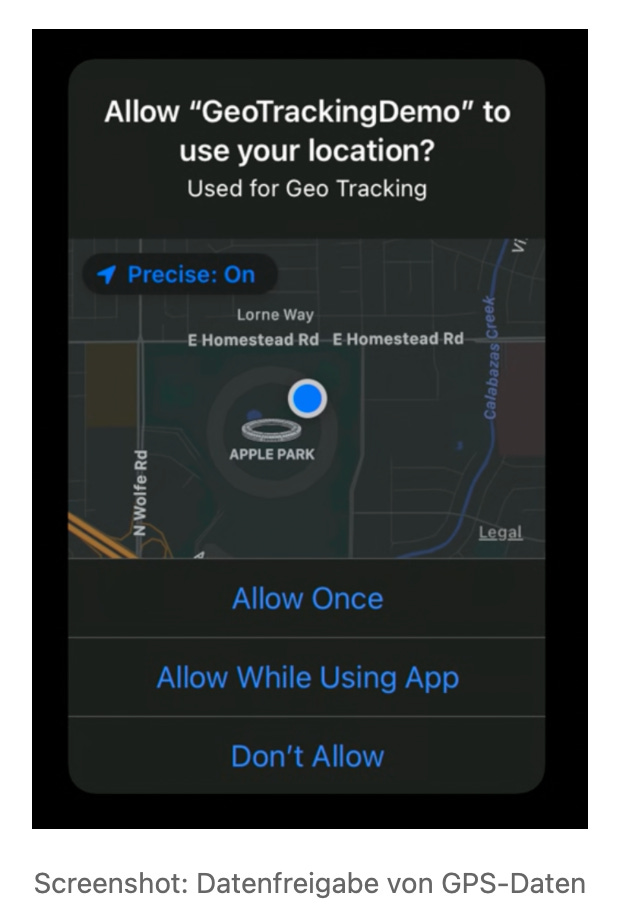

Dazu wird mein Device automatisch die GPS-Koordinaten mit weiteren Daten verknüpfen. Nur wenn ich die passende App installiert habe und dadurch ein OK gebe wird an meinem Standort überprüft ob es dazu 3D-Inhalte im Format USDZ gibt und diese dann angezeigt.

Hört sich ja eher Unspektakulär an?

Da nun aber mehrere Personen, mit gleicher App auf dem iPhone die gleiche AR-Szene erleben können und diese Szenen auch interaktiv sein können (Meine Playlist mit Beispielen) ist das schon ein guter Schritt in Richtung Reallife-Metaverse. Solche AR-Portale wären dann auch ÜBERALL möglich:

Noch nicht überzeugt das Apple 2 Jahre vor Meta das Reallife-Metaverse gestartet hat? Wer nun meine "Spurensuche" in den Apple-Infos verfolgen mag...

Chronologie von Apples AR-Plänen

17. April 2013: Metaio

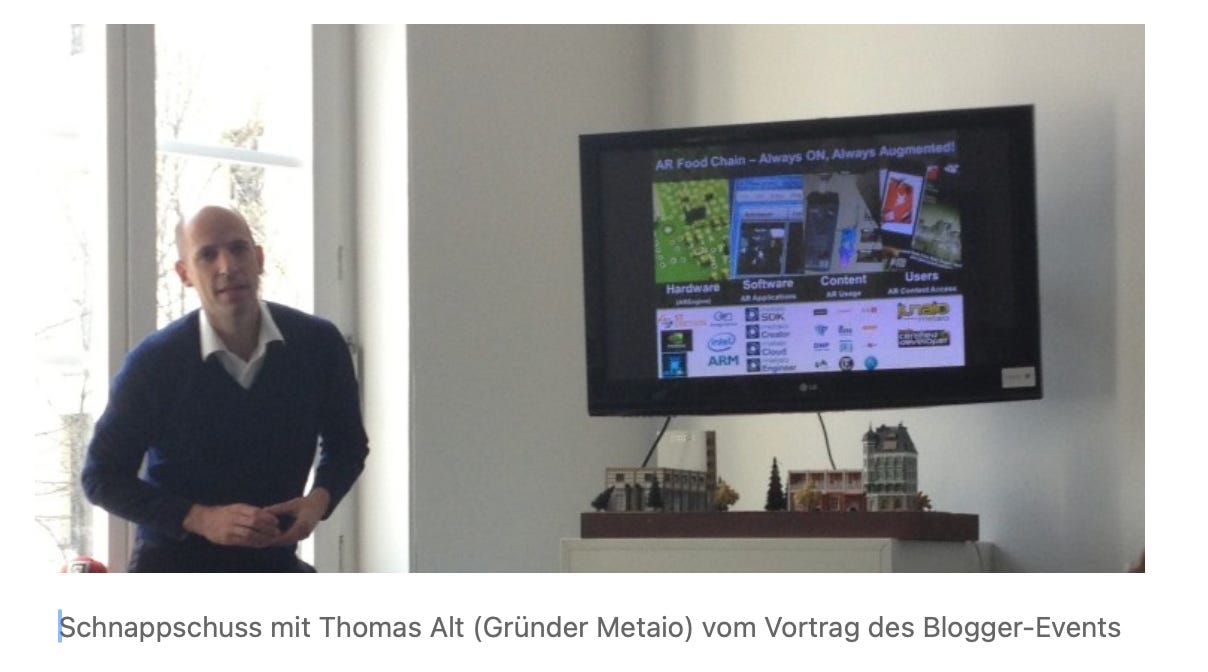

Ich hatte 2013 die Firma Metaio im Rahmen eines Tech-Blogger-Events in München besucht. Danke nochmals an Anett Gläsel-Maslov, damals PR bei Metaio!

Eine Reise mit langfristigen Konsequenzen für mein berufliches Leben. Hatte mich 2010 als Berater Selbstständig gemacht und plante die nächsten Schritte...

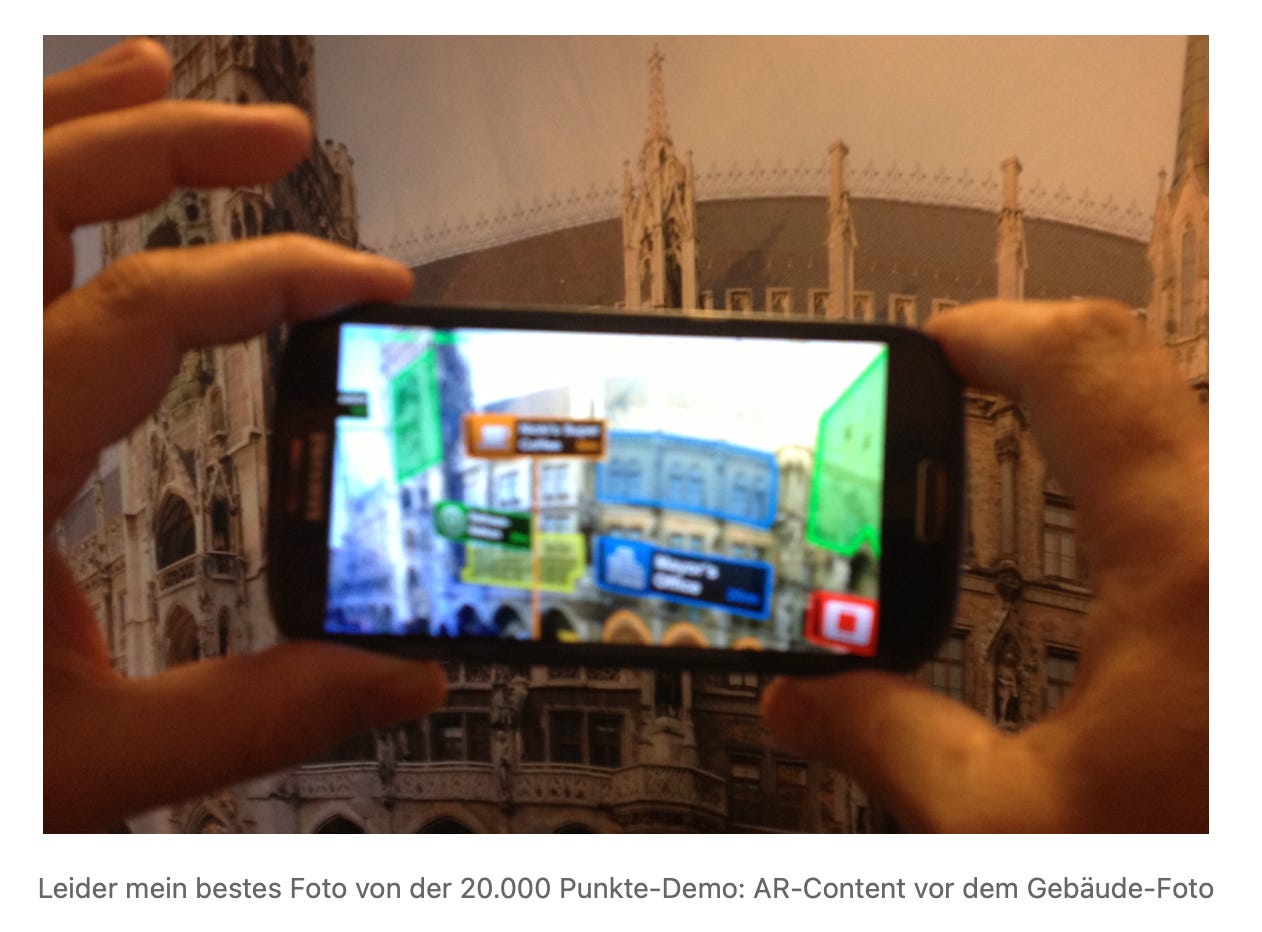

War beim Besuch besonders fasziniert gewesen von dem neuen AR-Chip den Metaio & Ericsson entwickelt hatten: Statt 2.000 AR-Datenpunkte konnte der neuen Chip bis zu 20.000 AR-Punkte in Echtzeit verfolgen.

Ein Meilenstein, nun in der Hand von Apple: In Nachhinein frage ich mich ob diese Patente die Grundlage für den neuronalen Chip-Part der heutigen Apple-Prozessoren bildete?

Deren AR-Real-World-Browser Junaio war der Hammer: Mit GPS-Koordinaten an einem realen Ort ein 3D-Objekt "anheften". Und das vor 10 Jahren, ganz ohne das Wort "Metaverse".

Die gesamte Metaio-AR-Entwicklung mit dem AR-Browser und Co. verschwand nach dem Kauf 2015 für circa zwei Jahre in der Versenkung. Ein Teil der Metaio-Mannschaft, der für Android entwickelt hatte, tauchte später als Team rund um "AR Core" von Google wieder auf. Der größere Teil verblieb jedoch bei Apple in München, Stichwort "AR Kit".

2017: AR-Kit

Im Frühjahr 2017 spazierte ich in den Apple Store meines Vertrauens am Centro Oberhausen und sah diese Animation auf allen Bildschirmen und jedem Display.

Ich hatte ein Metaio-Flashback bei dem Anblick. Mir war klar, im Rahmen der nächsten Keynote wird es KNALLEN: Da kommt was aus der AR-Ecke!

Im Rahmen der Entwicklerkonferenz WWDC stellte Apple dann tatsächlich im Sommer "AR Kit" vor und es kam mir vor wie eine erste, winzige Integration von Metaios Ideen: Apple legte so seinen Grundstein für die vielen weiteren Entwicklungsschritte.

2018: AR Quick Look

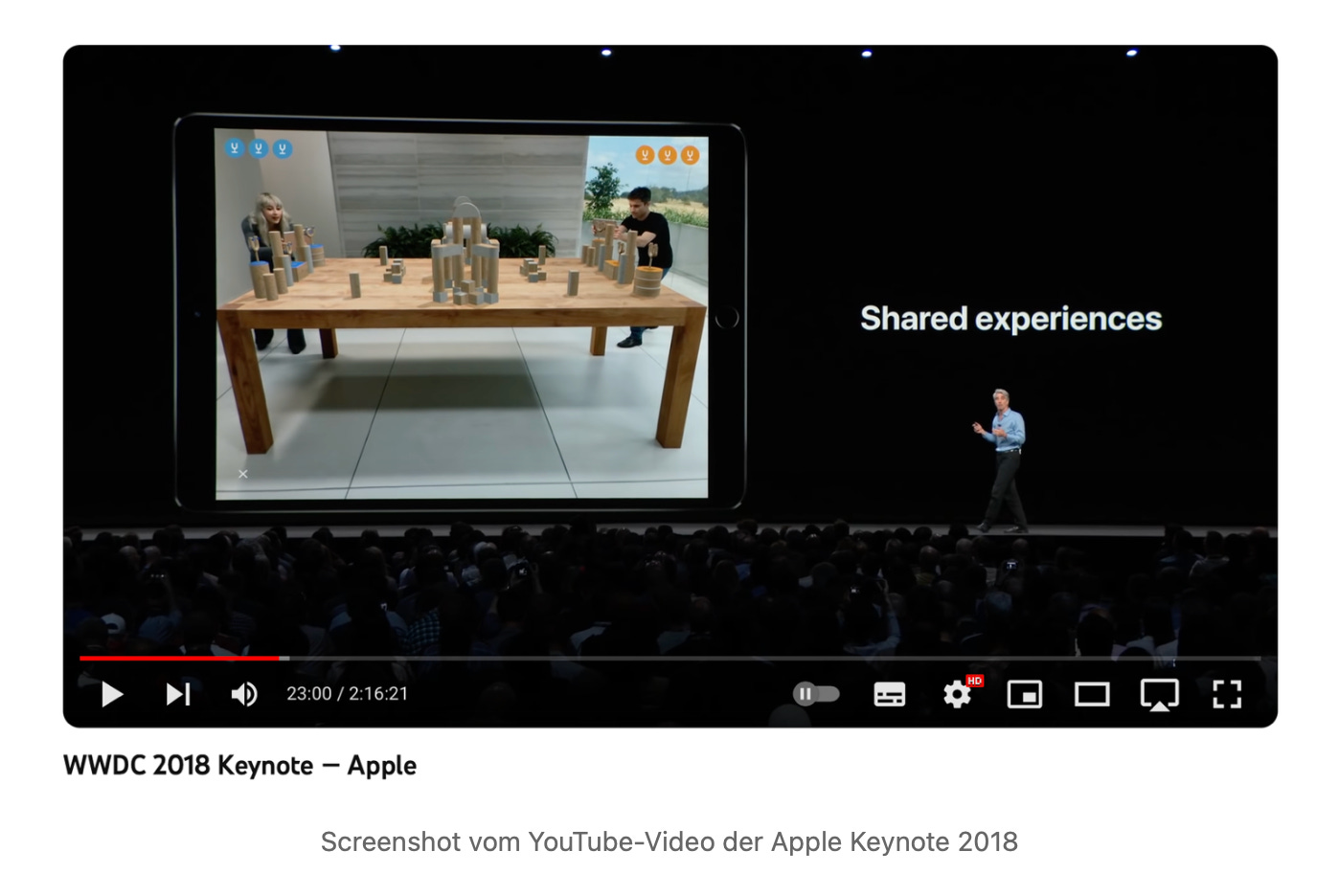

2018 wurde mit AR-Kits 2.0 ein Schwung neuer Funktionen eingeführt: Dazu gehörte u.a. die Einführung von AR Quick Look (Erklärvideo), welches auf Basis von Open USD (USDZ) AR-Inhalte ohne App oder Web-Browser anzeigen kann. Außerdem war sehr dem Zeitpunkt Multi-User AR möglich. (Mein Demovideo).

2019 & 2020: Reality Kit, Reality Composer & Spatial Audio

Mit "Reality Kit" folgten fortgeschrittenere Funktionen für den AR-Bereich, Reality Composer erlaubt es 3D-AR-Szenen "wie mit Powerpoint" zu gestalten und Spatial (3D-) Audio erlaubte immersive Hörerlebnisse. (Mein Demovideo zu Spatial Audio)

2021 & 2022: Object Capture & Room Plan

"Object Capture" erlaubte es via Photogrammetrie Objekte in 3D-Modelle umzuwandeln. Apple beging den Coup diese Funktion direkt ins Betriebsystem zu integrieren. "Room Plan" ermöglichte es einen ganzen Raum wie zum Beispiel das Homeoffice oder die ganze Wohnung.

Fast unbemerkt: 2020, die "AR Cloud"

Was in der obigen Auflistung fehlt ist eigentlich die Info, das Apple "sein Metaverse" schon zwei Jahre vor Meta gelauncht hat: Das Apple-Reallife-Metaverse aka "AR Cloud" ist seitdem in der Betaphase.

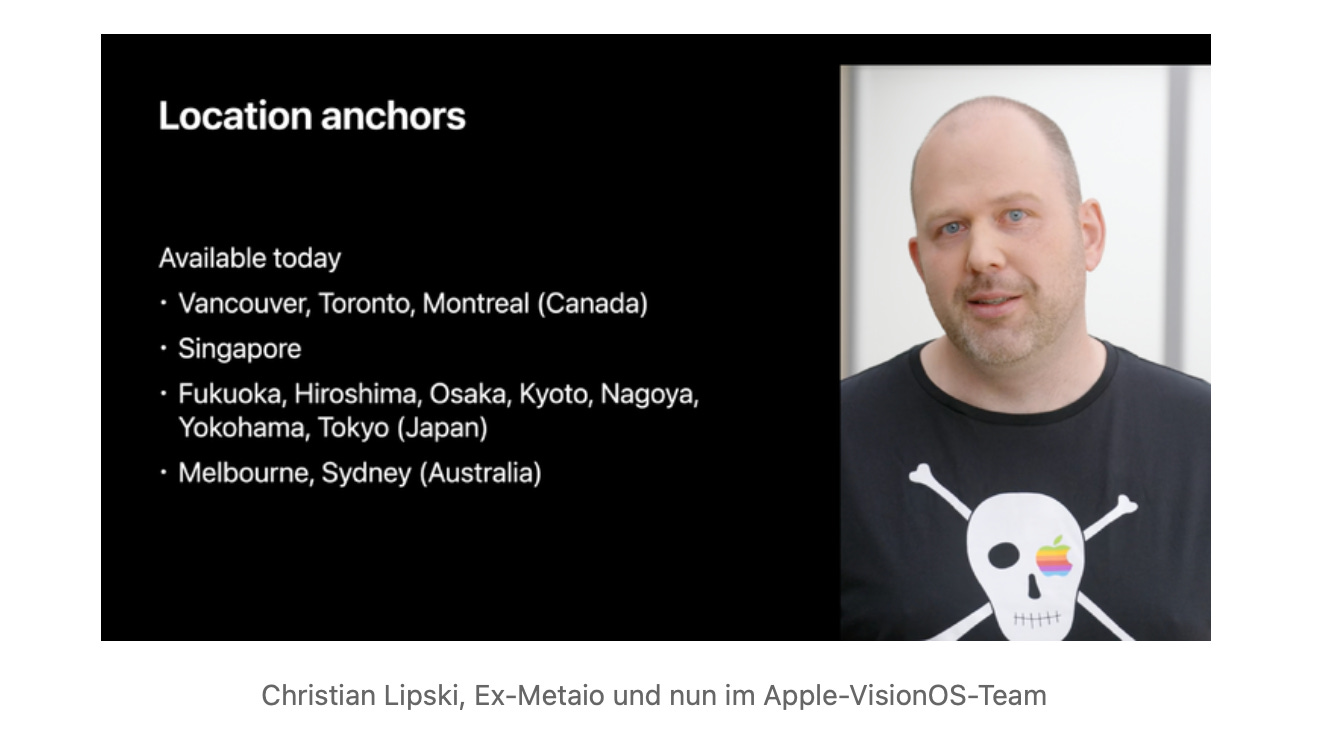

Es wurde auf der "State of the Union"-Keynote - nach der öffentlichen Keynote - angekündigt, wenn auch zuerst nur für circa 20 Städte in den USA und London. Technisch spricht Apple von Location Anchors, also Verankerung von 3D-Inhalten an einem realen Ort.

2022 wurde diese Liste um 12 weitere Städten ausgeweitet:

Was kommt nun?

Natürlich gibt es Stolpersteine bei dem ganzen Thema: Neben rechtlichen Fragen wie Markenrecht oder "wer darf über meinem Haus ein 3D-Objekt anbringen" - drum gibt es ja zu beiden Themen schon eine Newsletterausgabe - gibt es viele technische Dinge zu beachten.

Was ja heute, 10 Jahre nach dem Metaio-Besuch, mein Thema ist: Ich verbinde halt gern Technik mit Vertrieb = SalesTech. 2015 wollte ich just Metaio-Partner werden, als Apple die Firma kaufte.

"Show, don´t tell" reicht mir nicht.

Ich lasse heute gern mit meiner Agentur Kreative KommunikationsKonzepte GmbH die Interessenten meiner Kunden Produkte und Dienstleistungen erleben.

Und das geht mit Augmented Reality optimal: Fünf schöne Beispiele gibt es zum Ausprobieren. Dazu habe ich für die Daten zur potentiellen Umsatzsteigerung, zur Hardware und zur Präsentationssoftware zusammengestellt.

Weiterführende Links

Neben meinem LinkedIn-SalesTech-Newsletter kann ich den geneigten Lesern diese Videos aus meinem YouTube-Channel ans Herz legen:

- Was ist Open USD?, dem Open Source-Dateiformat, welches Apple für seine AR-Cloud nutzt, diesen gibt es auch als Newsletter-Beitrag. USD wird auch im Industrial Metaverse genutzt.

- Why Did Apple get into Maps? Absolut hörenswerte Podcast-Folge (120 Min.) zum Weg von Apple zu einer eigenen Kartenlösung. Ohne Karte keine "Location Anchors", kein "Real-Life-Metaverse".

- Was ist / Wozu das Metaverse? Mein heutiges Video auf YouTube, wurde von den Zuschauern angefragt. Ein Spaziergang am Baldeneysee...

- Apple Vision Air - Made for iPhone: Ich trage so wie in diesem Artikel gern Informationen zusammen. Im Video geht es um die Möglichkeiten aus jedem iPhone eine kostgünstige AR-Brille zu machen

- Apple vs. Metaverse, ein Livetalk am 16. Oktober auf LinkedIn und YouTube mit Thomas Riedel vom Metaverse-MeetUp, Kai Heddergott und mir, Gerhard Schröder

- Wenn gewünscht stelle ich die Nutzungszenarien für die Apple Vision Pro vor. Bisher gab es zu dem Spatial Computing-Thema zwei Ausgaben: Arbeitstier für den deutschen Mittelstand und zu 3D-Websites der Zukunft.

- Ich habe ja schon einige Mal im Newsletter einen Blick auf Apples Augmented-Reality-Pläne geworfen: Begriffe aus Patenten, Brillen-Design, das UX in einem Spielfilm entdeckt, die Vision Pro fürs Büro bewertet und zuletzt Websites mit Apples AR-Content in den Fokus genommen.

Wer weitere Gedanken von mir lieber via Email erhalten mag (Email-Newsletter): Die gibt es neben LinkedIn auch via Substack-Abo: SalesTech: Verkaufen trifft Visuelles.

Viele Grüße aus Velbert,

Gerhard Schröder

PS: Bis in drei Woche - Herbstferienpause. Dann wieder alle zwei Wochen frische Gedanken zu SalesTech. Kleiner Ausblick: Vielleicht habe ich dann schon wieder ein konkretes Open-USD-Kundenbeispiel zur Hand. Vision-Pro-Ready. 😎

PSS: Mich interessieren natürlich die Gedanken meiner LeserInnen zu dem Thema. Also, was denkst Du beim Real-Life-Metaverse? Egal ob von Apple, Google und Co. Wer statt eines Kommentars lieber den direkten Austausch sucht: Calendly-Terminvereinbarung oder Direktnachricht an Gerhard Schröder.

SalesTech: Verkaufen trifft Visuelles ist eine von Lesern unterstützte Publikation. Um neue Posts zu erhalten und meine Arbeit zu unterstützen, erwägen Sie, ein kostenloser oder kostenpflichtiger Abonnent zu werden.