Lasst uns über Avatare reden

Wieder ein Substack-Special: Er erhält als LinkedIn-Archiv-Repost aber bald einen Folgebeitrag im Newsletter mit Infos zu Apples Vision Pro und dem Thema "Videokonferenz" mit Apples Personas etc.

Vor langer Zeit entstand der Begriff „Avatara“ als Bezeichnung für einen Gott, der die Gestalt eines Menschen oder Tieres annimmt. Im Zeitalter des Internets wurde das daraus abgeleitete „Gravatar“ in der Blogosphäre bekannt, als Ausdruck für ein universales Profilbild einer Person auf verschiedenen Wordpress-Instanzen. Spätestens seit dem Film Avatar – Aufbruch nach Pandora wird beinahe jeder einmal dieses Wort gehört haben.

Ich habe wieder eine Gast-Autoren gewinnen können: Thomas Kumlehn aus dem Team meiner Agentur. Er gehört zu unserem “Immersive-Team” im Bereich Code. Die Agentur ist in 4 C´s aufgeteilt: Consulting, Capture, Creation und Code.

Was ist ein Avatar?

Und so bezeichnet der Begriff auch im Zusammenhang mit Hashtag#VirtualReality und dem Hashtag#Metaverse die Gestalt einer realen Person in einer virtuellen Welt, ähnlich dem „Gravatar“. Da diese Gestalt nicht zwingend das Abbild der realen Person sein muss, kann ein Avatar auch eine Gestalt annehmen, die eher der Rolle als dem Aussehen des Users entspricht.

Wir alle nehmen im Alltag verschiedene Rollen ein: Vater, Freund, Geschäftspartner, Hobbygärtner. Wir sind es gewohnt, für diese Rollen unsere Kleidung zu Wechseln. Gerade wir Deutschen kennen ja passende Funktionskleidung für die entsprechenden Aktivitäten: Outdoor-Hose zum Gärtnern, Smoking für den Ball oder Jeans in der Freizeit.

Wechseln wir also in Zukunft in VR unser Outfit via Knopfdruck? Der Vergleich hinkt.

Des Avatars neue Kleider

Im echten Leben wechseln wir für verschiedene Rollen zwar die Kleidung, einige wichtige Merkmale bleiben jedoch gleich, etwa unser Gesicht. Daher gilt es, so wie für Firmen-Logos in 3D (Wenn Logos auf VR & AR treffen) auch unser Outfit als Teil der „Metaverse-Personenmarke“ zu gestalten.

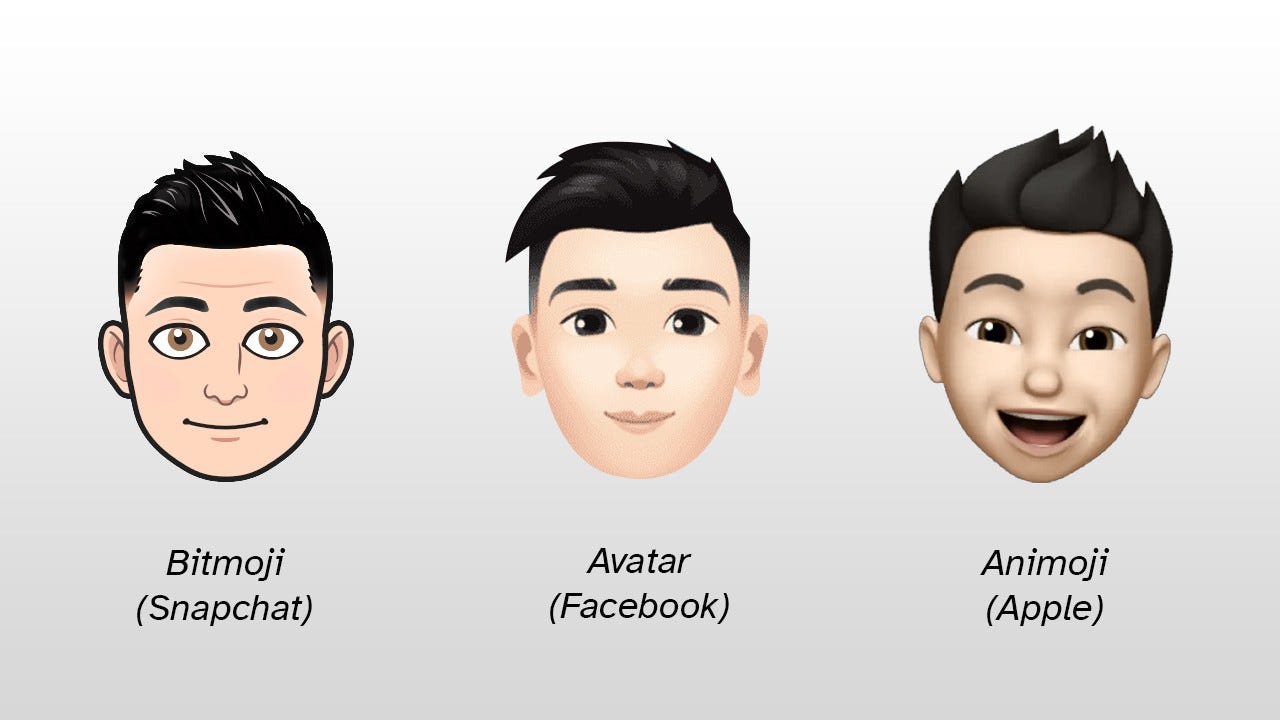

Mit dem Avatar-Gesicht haben wir User schon angefangen. Wir gestalten unser Ebenbild für Snapchat, Facebook und Co. So wie hier...

Apple bietet aber nicht nur die Gestaltung des eigenen Gesichts an, sondern auch die Gestaltung des Oberkörpers. Siehe dazu mein Video HowTo: Apple-Animoji erstellen.

Wer einen weiteren Avatar gestalten möchte, sollte sich Ready Player Me anschauen. Dort sieht man, wie die Gravatar-Idee aus Blog-Zeiten aussieht, wenn man sie in 3D-Welten überträgt.

Der Weg hin zu einem universellen Avatar, der einen auf mehreren, oder gar allen Plattformen repräsentiert, ist noch lang. Wie so oft im Frühstadium einer technischen Entwicklung gibt es eine Vielzahl verschiedener Anbieter, auf denen man sich sein "virtuelles Ich" schon mal reservieren kann.

“SalesTech: Verkaufen trifft Visuelles” ist meine Substack-Publikation, neben YouTube, zwei Podcasts und Co. Alle zwei Wochen Impulse zum Thema Visuelles, Verkaufen und Apple.

Exkurs: Mein TEDx-Erlebnis 2011

Vor nun 11 Jahren war ich in Frankfurt am Main auf einem TEDx-Event und lernte dort Elisabeth von Samsonow, Gunter Dueck und Ibrahim Evsan kennen. Gerade an den besonderen Vortrag von der Philosophin Elisabeth von Samsonow kann ich mich gut erinnern, nicht nur weil er als Video eingespielt wurde (im Gegensatz zu allen anderen Live-Vorträgen des Abends). Auch war es, wie es mir zunächst schien, der schwächste Vortrag des Abends. Rückblickend jedoch ist es genau dieser Vortrag, der am Längsten nachhallt, bis heute. Leider gibt es davon keine Aufzeichnung.

Sie sprach über unsere Seele, wie wir sie in der Vergangenheit „in uns“ trugen, und wie wir heute unsere „externe Seele“ in Form unserer Fotos in Social Media nach außen tragen.

Was mich an Avatare erinnert und den Weg zu Thomas Kumlehns Zeilen weist...

Unter der Avatar-Haube

"Als Programmierer schaue ich gerne den Avatar-Anbietern „unter die Haube“.

Und ich betrachte wie sich die Gestaltung und Zusatz-Elemente unterscheiden. Die einen bedienen den kleinsten gemeinsam technisch machbaren Nenner und dabei bleiben schon einmal Dinge wie „User streckt die Zunge raus“ auf der Strecke.

Obwohl die neu vorgestellte Meta Quest Pro extra eine Kamera nur für die Mundbewegungen eingebaut hat, das also erkennen könnte, taucht die Zunge auch in der kurz darauf neu überarbeiteten Schnittstellenbeschreibung nicht auf. Jahrelang hatte man nur der Stimme gelauscht und den Mund danach bewegt.

Warum also dem Ziel „Expressivität des Users“ zustreben?

Betrachten wir die Zusatz-Elemente: Wenn ich an einem virtuellen Meeting teilnehmen möchte, aber in real life (IRL) als gläubiger Sikh einen Turban trage, finde ich diesen bisher nur bei Apple. Andere Plattformen bieten mir dafür eher Schnickschnack an.

Und unter der Haube?

Die meisten, zum Beispiel Meta oder Ready Player Me-Avatare, präsentieren ein Gesicht als hunderte von 3-seitigen Polygonen (Tri-Meshes) wie es auch im letzten Jahrtausend üblich war und wenn ein Gerät das nicht schnell genug darstellen kann, wird einfach ein kantigeres Gesicht mit weniger Eckpunkten verwendet.

Apple hingegen setzt auf ein modernes Verfahren (SubDivision Surfaces und realtime Tesselation). Hier sind es am Ende sogar tausende von Dreiecken, die werden aber 60 mal pro Sekunde aus dem sehr speichersparenden Datenmodell neu berechnet, ganz „smooth“ und ohne ungewollte Kanten. Die Technik ist seit Jahren OpenSource - aber manche bestehen leider auf dem „kleinsten gemeinsamen Nenner“.

Unreal 5 (Nanite) geht einen ähnlichen, dynamischen Weg."

In Anlehnung an die Tradition von Bernd Geropp, der seinen Podcast immer mit einem Zitat beendet, zum Abschluss noch diese Zeilen von Erasmus von Rotterdam:

Der Körper kann ohne den Geist nicht bestehen, aber der Geist bedarf nicht des Körpers.

Viele Grüße aus Velbert,

Gerhard Schröder